エッジAIとは、クラウドに頼らず、現場の機器や端末そのものがAIの計算を行う仕組みのことです。たとえば工場のラインや車載カメラなど、リアルタイム性が求められるアプリケーションでは、クラウドにデータを送ってAI処理結果を待つのでは間に合いません。現場でAIが即座に判断してリアクションできることが、リアルタイム性能を高めるカギとなります。

エッジAIの開発を始めるとき、「どんなハードウェアを選ぶべきか」は多くのエンジニアにとって悩みどころです。本記事では、手軽に入手できる汎用的なRaspberry

Piと、エッジAI専用に開発されたQualcomm

Dev-Kitの違いを、初心者の方にもわかりやすく解説します。エッジAIを導入するにあたって、ハードウェア選定で迷っている方が、自分の用途に合った最適な選択ができるよう、用語や仕組みも丁寧に説明していきます。

エッジAIに求められる性能要件

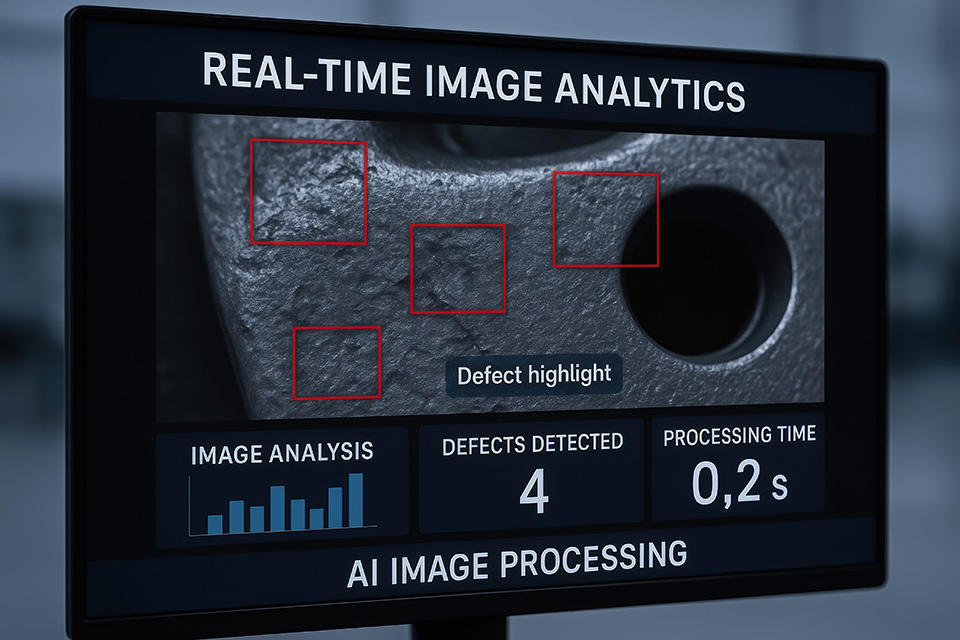

まず、なぜエッジAIが注目されているのかをカメラアプリケーションを例にとって整理します。たとえば車載カメラや工場の自動検査装置では、カメラがとらえた画像をすぐにAIで解析し、異常や危険を検知したら即座にアラームを出す必要があります。こうした用途では、クラウドにデータを送って結果を待つのでは遅すぎるため、カメラ端末自身がAIの画像認識処理までをこなすエッジAIが必要です。

エッジAI カメラアプリケーションのイメージ

エッジAI開発で特に重視されるのは、リアルタイム性、AI推論の精度、そして保守性が良く長期間安定して使えることです。たとえばリアルタイム性とは、カメラが人や物を検知してから、ほんの数ミリ秒で結果を出せることを意味します。これが遅いと、事故や不良品の見逃しにつながります。

またAI推論の精度も重要です。AI推論とは、AIが学習した知識を使って新しいデータを判定する処理のことです。たとえば画像から人や物体を見分ける物体認識では、誤検知や見逃しがあると現場の安全や品質に直結します。AIモデルの精度は、使うハードウェアの性能や、どんなAIアクセラレーターを使うかによっても大きく変わります。

さらに、量産や長期運用を考えると、ハードウェアが壊れにくく、安定して供給されることも大切です。最近ではOTA(Over-the-Air)と呼ばれる、ネット経由でソフトやAIモデルを自動更新できる仕組みも求められています。これにより、現場に行かなくても不具合修正や機能追加ができるようになります。

汎用キットRaspberry Piの特徴

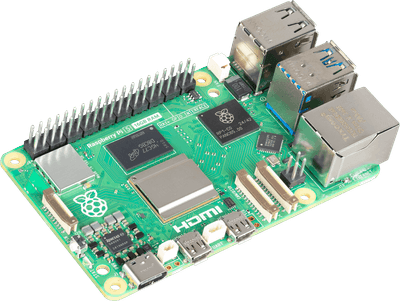

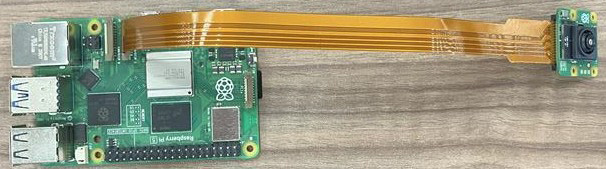

Raspberry Pi 5 (出典:Raspberry Pi)

Raspberry Pi 5は、手のひらサイズの小型コンピューターで、教育や試作、IoTなど幅広い用途で使われています。最新のRaspberry Pi

5は、前の世代よりも2〜3倍の処理性能を持ち、4K映像の出力やPCIeによる拡張も可能です。価格が手頃で入手しやすく、世界中にユーザーがいるため、困ったときにネットで情報を探しやすいのも大きな魅力です。

ただし、Raspberry

Pi単体では高度なAI推論処理は得意ではありません。そこで、Raspberry

Piで画像認識などのエッジAI処理を実現するためには、AIアクセラレーター付きのカメラモジュールIMX500を追加します。IMX500は、カメラで撮った画像をその場でAIが解析し、必要な情報だけをRaspberry

Piに送信します。これにより、Raspberry Piでも物体認識AIを簡単に動かすことができます。

Raspberry Pi5(左)+IMX500(右)の外観

一方で、Raspberry Piはもともと教育や試作を目的として開発された製品であるため、産業用途や量産品として利用する際には少し注意が必要です。たとえば、長期間に渡る安定供給が難しい場合や、産業現場で求められる堅牢性やセキュリティ機能が十分でない場合があります。

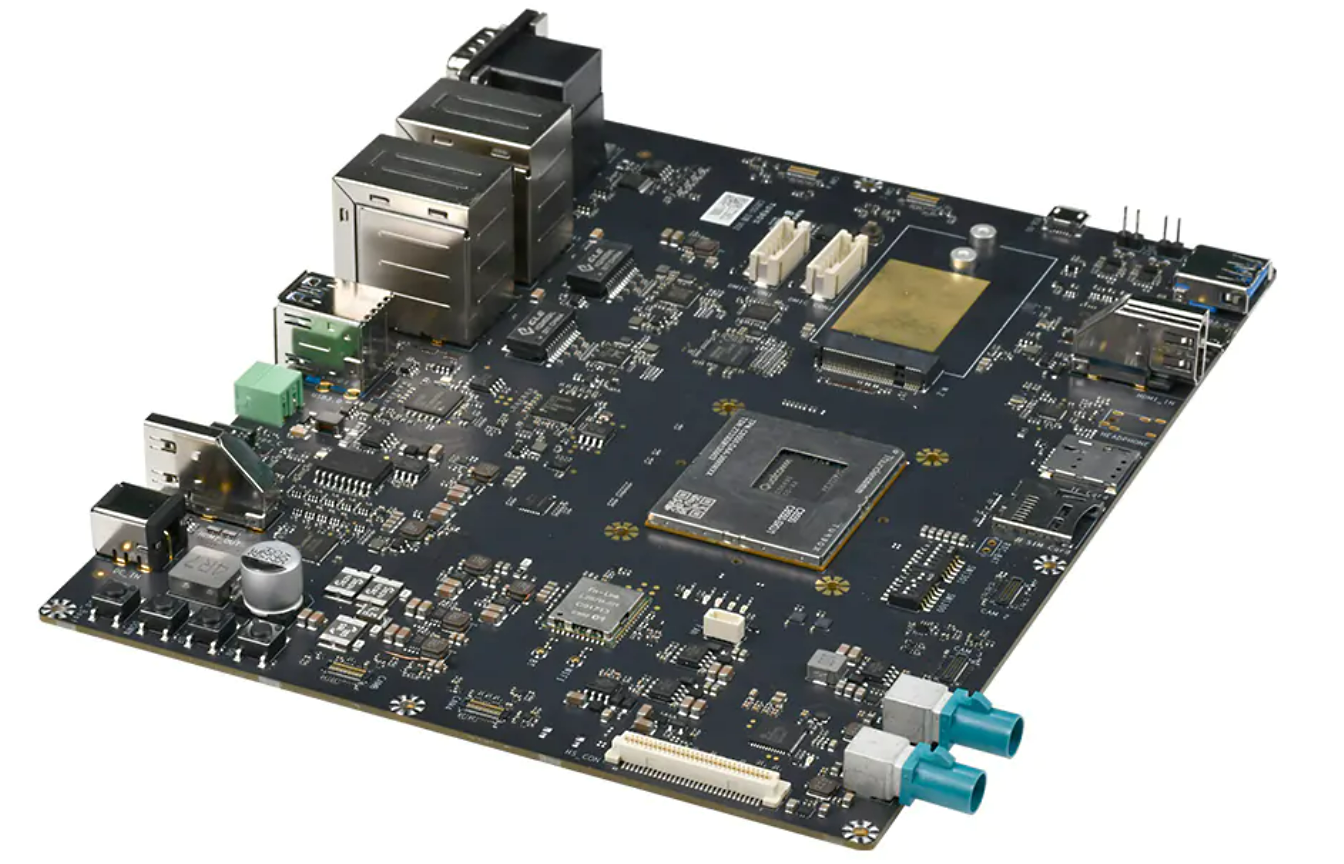

AI専用設計デバイスQualcomm Dev-Kitの特徴

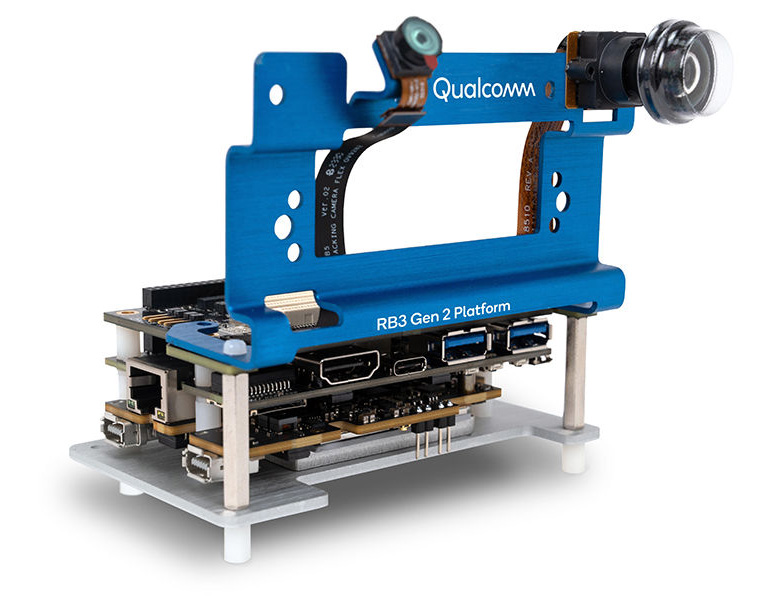

Qualcomm Dragonwing RB3 Gen 2 Development Kit(出典:Qualcomm)

Qualcomm Dev-Kit(RB3 Gen2)は、産業用途やIoT機器向けに設計された開発キットです。中心となるプロセッサーQCS6490には、8つのCPUコア(Kryo 670)と高性能なGPU(Adreno 643)、そしてAI専用のNPU(第6世代AIエンジン)を搭載しています。NPUとは、AIの計算を効率よく高速にこなすための専用回路で、RB3 Gen2では最大12TOPS(1秒間に12兆回の計算ができる性能)を実現しています。

QCS6490簡易ブロック図

このような専用設計デバイスの強みは、AIの物体認識や音声認識など、計算量が多い処理でもリアルタイムでこなせることです。

なお、Qualcomm

Dev-kitは評価用のため量産向けにはお使い頂けません。量産向けの販売はチップかSOM(System On Module)となります。

Qualcomm Dev-Kit(RB3 Gen2)の特徴

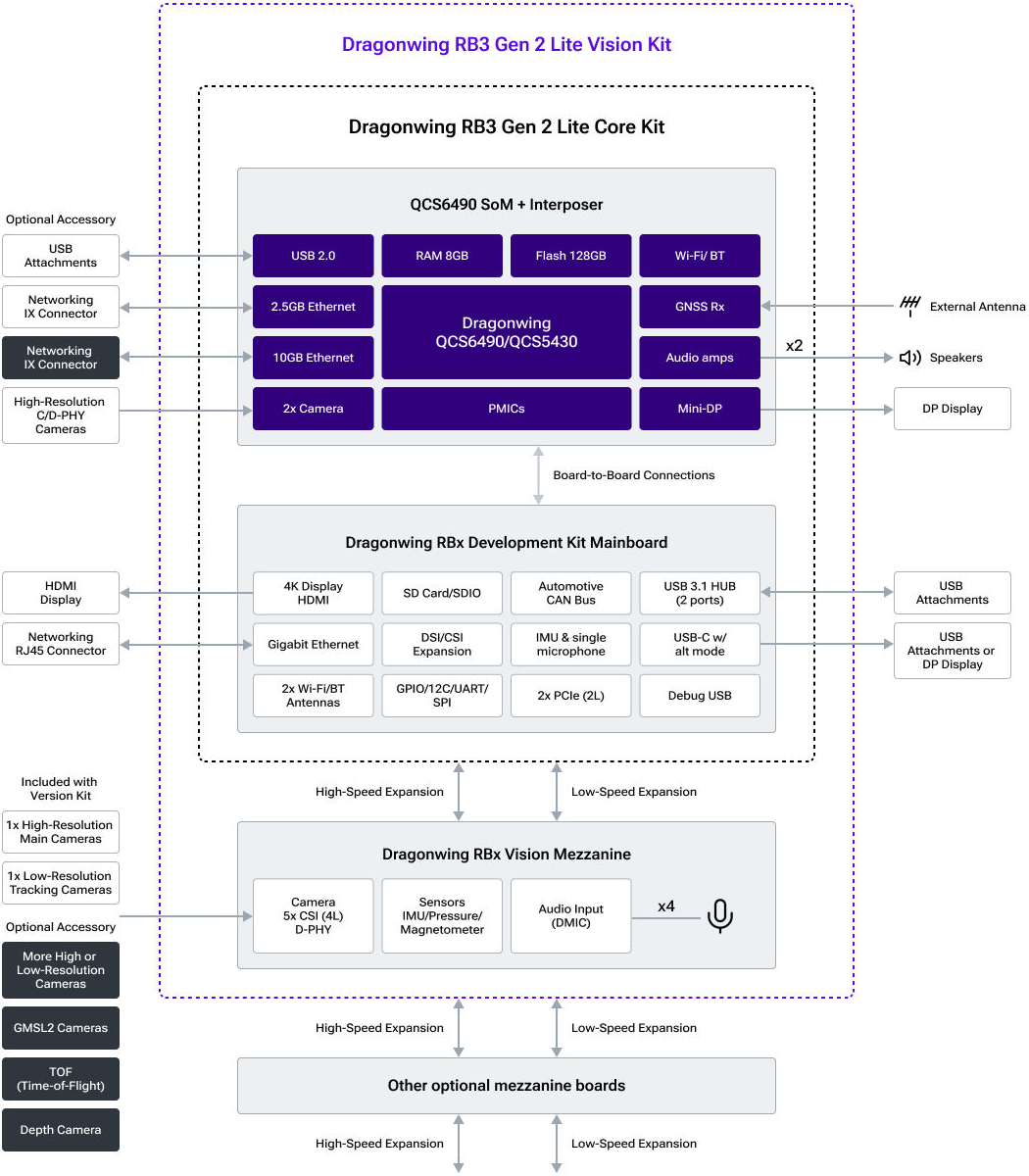

Qualcomm Dev-kit (RB3 Gen2)概要

Qualcomm Dev-kit (RB3

Gen2)はLinux、Android、Ubuntu、Windowsなど複数のOSに対応しています。また、USB、PCIe、MIPI、Ethernetなど豊富なインターフェイスを備え、Wi-Fi

6EやBluetooth 5.2による高速・低遅延通信もサポートします。さらに、Qualcomm AI

Hubとの連携により、AIモデルの開発・学習・デプロイが容易で、プロトタイプから量産設計への移行をスムーズにします。

ユースケースとしては、ロボティクス、産業用オートメーション、スマートセキュリティ、AIビジョン、スマートデバイスなどが挙げられます。例えば、工場の異常検知や安全管理、物流ロボットの自律制御、監視カメラによるリアルタイム映像解析など、産業現場で求められる高精度・低遅延のAI処理に最適です。また、長期供給保証やOTAによるソフトウェア更新、セキュリティ機能の充実により、商用・産業用途でも安心して利用できます。

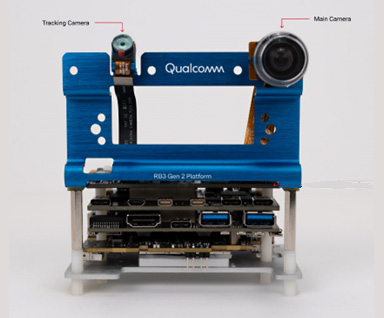

Qualcomm Dev-kit:Vision Kit(出典:Qualcomm)

Vision Kit特徴

カメラ

- Main Camera (IMX577 D-PHY 12MP):AIビジョンや画像認識の主要入力として使用

- Tracking Camera (OV9282 D-PHY 1MP):動きや位置を検出し、対象の追跡をサポート

メモリー(RAM)

- 6 GB LPDDR4x

ストレージ(onboard)

- 128 GB UFS Flash

ストレージ(external)

- 1x MicroSD Card Slot, PCIe expansion for NVMe

USB

- 1x USB 3.0 Type-C, 2x USB 3.0 Type-A, 1x USB 3.0 on high-speed expansion

- 1x USB 2.0 w/OTG

Audio

- 4x DMIC, 2x digital audio amplifiers

- I2S/Soundwire/DMIC expansion on low-speed connectors

センサー

- IMU (ICM-42688)

- Pressure sensor (ICP-10111)

- Mag sensor/compass (AK09915)

Qualcomm Dev-kit (RB3 Gen 2) Block Diagram(出典:Qualcomm)

AIモデルで異なる物体認識性能

ここからは、汎用キットRaspberry Pi 5+IMX500とAI専用設計Qualcomm Dev-Kit(RB3

Gen2)を使って、カメラでの物体認識AIを動かしたときの性能の違いを見ていきます。汎用キットに比べてAI専用設計キットのほうがより複雑な処理を必要とするAIモデルを動かすことができます。汎用キットRaspberry

Pi 5+IMX500ではMobilenet SSDという軽量なAIモデルを、AI専用設計Qualcomm Dev-KitではYOLOXという高精度なAIモデルを使用しました。

両キットの主な違いは、AI処理をどれだけ効率よく行えるかにあります。Raspberry Pi

5はAI搭載カメラIMX500の力を借りるものの、複雑なAIモデルの実行や高精度な処理には限界があります。一方、Qualcomm

Dev-Kitは強力なNPUを搭載しており、より複雑で高精度なAIモデルでもリアルタイムに処理できます。

Mobilenet SSDとYOLOXとは? 〜物体認識AIモデルの違いを解説〜

エッジAIの実力を測るうえで、「どんなAIモデルを使うか」はとても重要なポイントです。ここでは、今回の比較で使われているMobilenet SSDとYOLOXという2つの物体認識AIモデルについて、初心者の方にも分かりやすく説明します。

Mobilenet SSD(モバイルネット・エスエスディー)

Mobilenet

SSDは、スマートフォンや小型コンピューターのような計算資源が限られた機器でも動かしやすいように設計された、軽量な物体認識AIモデルです。

Mobilenetは、画像を特徴ごとに分解して効率よく処理するための工夫が詰まったニューラルネットワークの一種です。これにSSD(Single

Shot MultiBox

Detector)という、画像の中から一度に複数の物体を見つけ出す仕組みを組み合わせています。このモデルの最大の特徴は、処理が速く、消費電力も少ないことです。Raspberry

Piのような小型デバイスでも、リアルタイムで人や物体を検出できます。ただし、計算量を抑えるためにネットワークの構造がシンプルになっている分、複雑な背景や小さな物体の検出、あるいは多くの種類の物体を同時に見分ける精度は、より高性能なモデルに比べてやや劣る場合があります。

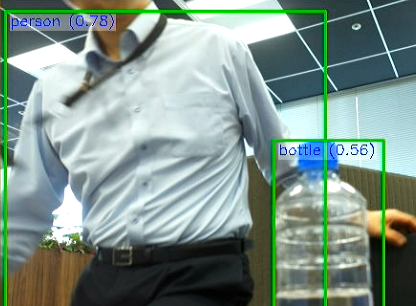

1枚の画像で認識できる物体が少ない

Mobilenet SSDでの物体検出イメージ

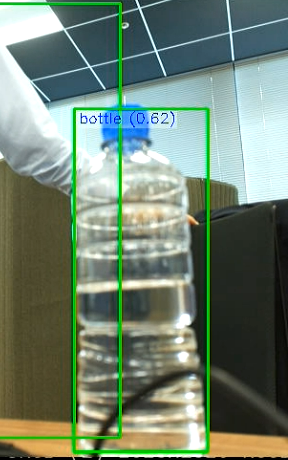

YOLOX(ヨーローエックス)

YOLOXは、近年登場した高精度かつ高速な物体認識AIモデルです。YOLOは「You Only Look

Once(1回見るだけ)」の略で、画像全体を一度に解析して、どこに何が写っているかを一気に判断するのが特徴です。YOLOXはその進化版で、従来のYOLOシリーズよりもさらに精度と柔軟性が高められています。

YOLOXは、複雑な画像や多くの物体が同時に写っている場面でも、正確に物体を検出できます。たとえば工場のラインで複数の部品を同時に認識したり、交通監視カメラで人や車、標識などを一度に見分けたりする用途に向いています。ただし、Mobilenet

SSDに比べると計算量が多く、動かすためにはより高性能なハードウェア(たとえばNPU搭載のQualcomm Dev-Kitなど)が必要です。

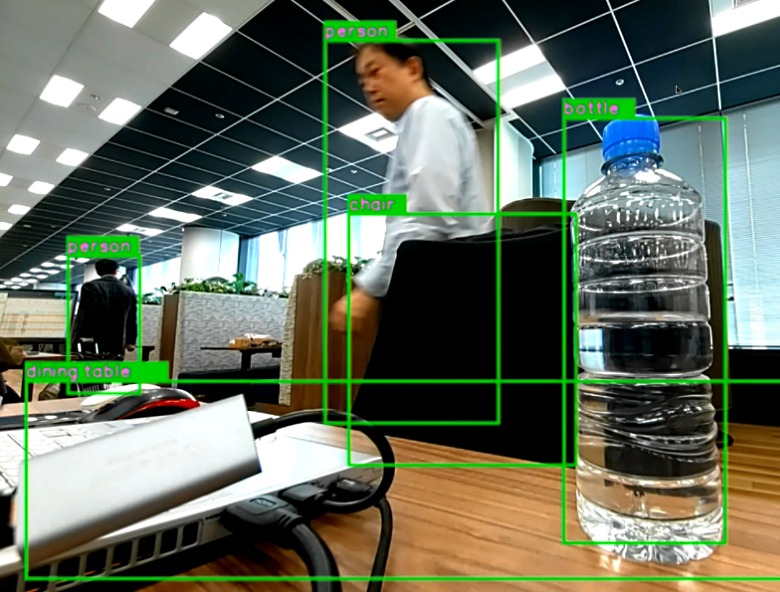

1枚の画像で認識できる物体が多い

YOLOXの物体検出イメージ

MobilenetSSDとYOLOXのどちらを選ぶべきか?

簡単にまとめると、Mobilenet

SSDは「軽くて速いけれど、精度や対応できる物体の種類には限界がある」モデル、YOLOXは「より多くの物体を高精度で検出できるが、動かすにはパワフルなハードウェアが必要」なモデルです。試作や教育用途、消費電力やコストを抑えたい簡易的な用途の場合はMobilenet

SSDが適しています。一方で、産業用途で高い精度や多機能性が求められる場合はYOLOXのような高性能モデルが適しています。

このように、AIモデルの選択は「どんな現場で、どんな目的で使うか」によって最適解が変わります。ハードウェアとAIモデルの組み合わせを考える際は、ぜひこの違いを意識してみてください。

Raspberry Pi5+IMX500で物体認識デモを動作させる

Raspberry Pi5+IMX500を使って、Mobilenet SSDの物体認識デモを動作させる手順を説明します。

使用機材

- Raspberry Pi 5 (4GB)

- Raspberry Pi AIカメラ (IMX500)

- microSDカード(Raspberry Pi OS 64bit インストール済み)

- インターネット接続(Wi-Fiまたは有線)

- 電源アダプター(5V/5A)

- モニターとMicro HDMIケーブル

- USBマウス/USBキーボード

手順

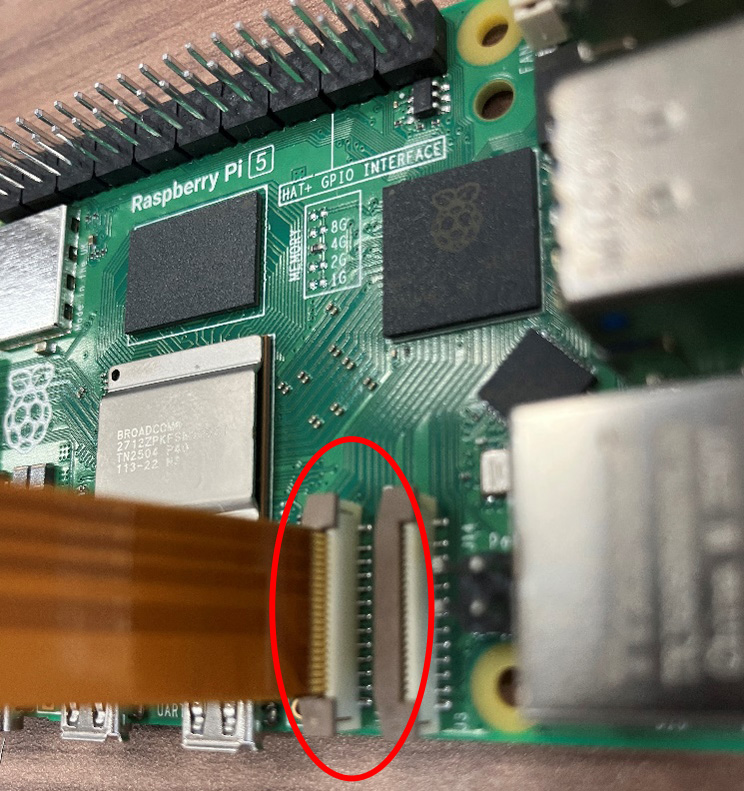

1)IMX500モジュールのケーブルを交換します。出荷時のFPCケーブルを取り外し、IMX500パッケージに同梱されている、先が細くなったケーブルに差し替えます。

IMX500のRaspberry Pi5用ケーブル(MIPI-CSI)

2)IMX500のケーブルをRaspberry Pi側のCSIカメラコネクターへ接続します。

Raspberry Pi5側CSIコネクター位置

3)Raspberry Pi5上のTerminalで以下のコマンドを実行して、IMX500のファームウェアをインストールします。(事前にRaspberry Pi5でのWi-Fi設定が完了している必要があります。)

sudo apt update && sudo apt full-upgrade

sudo apt install imx500-all

4)インストール終了後、以下のコマンドでRaspberry Pi5を再起動します。

sudo reboot5)Picamera2のライブラリーを使用して物体認識モデルのデモを実行します。

Picamera2とは、Raspberry

Piでカメラ機能を使うためのPythonライブラリーで、このライブラリーを使うと、Pythonプログラムから簡単にカメラの映像を取得したり、写真や動画を撮影したり、プレビューを表示することができます。

まず、以下のコマンドをTerminalで実行し、picamera2をインストールします。インストールには数分かかります。

sudo apt install python3-opencv python3-munkres

git clone https://github.com/raspberrypi/picamera2.git6)Picamera2インストール後、picamera2/examples/imx500フォルダーへ移動します。

7)以下のコマンドでrpicam helloを起動し、Mobilenet SSDによる物体認識デモを実行します。

rpicam-hello -t 0s --post-process-file /usr/share/rpi-camera-

assets/imx500_mobilenet_ssd.json --viewfinder-width 1920 --viewfinder-

height 1080 --framerate 30

Raspberry Pi5+IMX500での物体認識例

以上でRaspberry Pi5+IMX500のセットアップは完了です。

Qualcomm Dev-kit (RB3 Gen2)で物体認識デモを動作させる

Qualcomm Dev-kit(RB3 Gen2)を使って、YOLOXの物体認識デモを動作させる手順を説明します。

使用機材

- RB3 Gen2 Vision Kit(Qualcomm Linux OSプリインストール)

- インターネット接続(Wi-Fiまたは有線)

- 電源アダプター(12V/3A)

- モニターとHDMIケーブル

- USBマウス/USBキーボード

手順

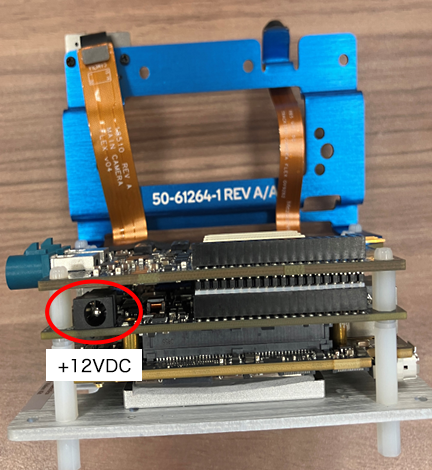

1)ACアダプターを+12VDCコネクターに接続します。

+12VDC電源コネクター位置

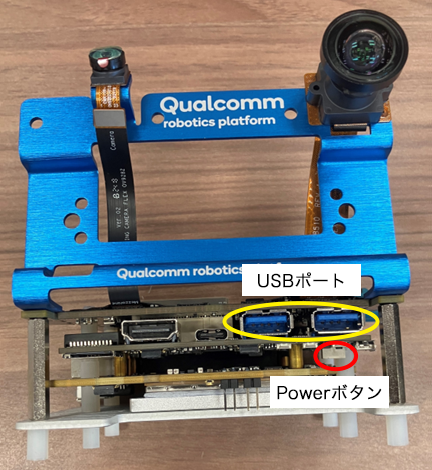

2)USBポートにマウスとキーボードを接続します。

3)Powerボタンを3–4秒押してシステムを起動します。

RB3 Gen2の電源と

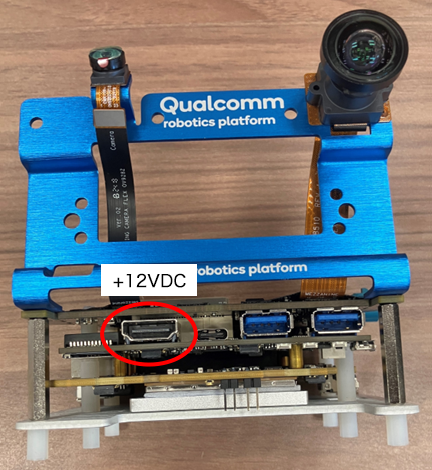

4)RB3 Gen2のHDMIポートとディスプレーをHDMIケーブルで接続します。

HDMIポート位置

5)システム起動後、ディスプレーに表示されたホーム画面の左上にQマークが表示されることを確認します。

Qマーク

6)ホーム画面左上のQマークをクリックし、Experience Application Demoメニューを表示させます。Wi-FiタブからWi-Fiの設定(SSIDとパスワードの設定)を行い、Wi-Fi statusがOnlineになることを確認します。

7)Applications設定でObject detectionを選択し、Startボタンを押します。

Experience Application Demoメニュー画面

8)Startを押すと、AIモデルが自動でインストールされます。Raspberry PiのようにTerminalでインストールコマンドを実行する必要はありません。数分後に物体認識が開始されます。

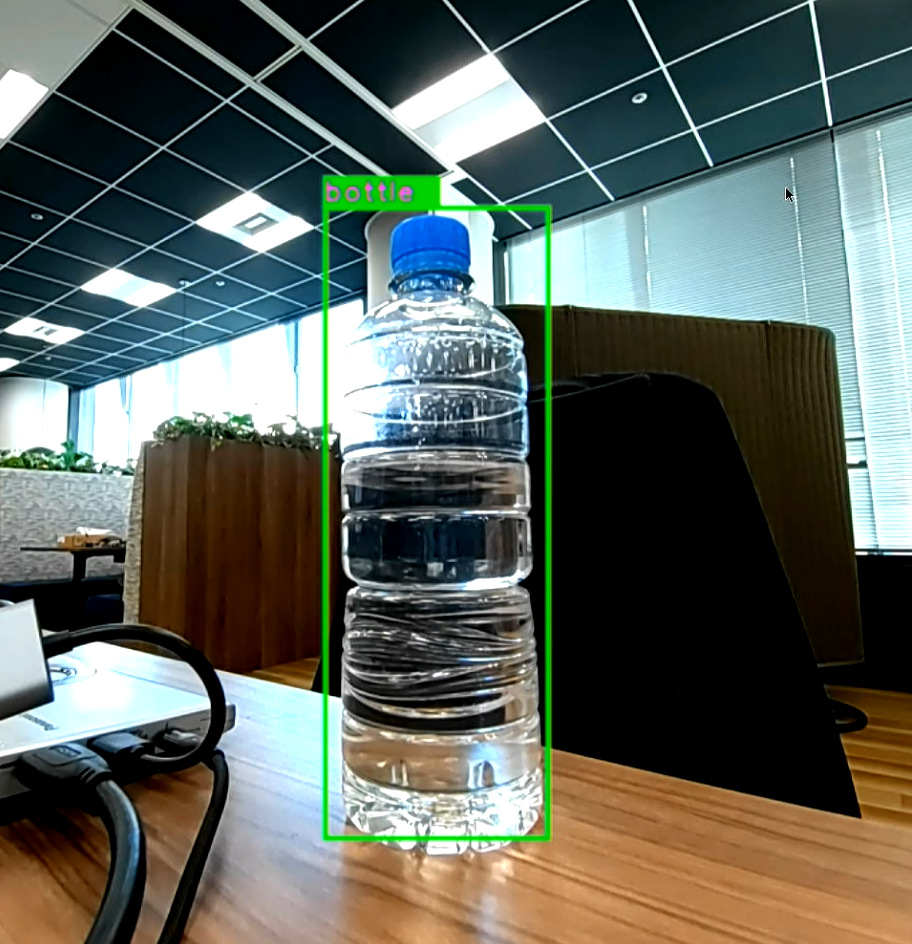

RB3 Gen2での物体認識例

以上でQualcomm Dev-kitのセットアップは完了です。

汎用キットとAI専用設計Qualcomm Dev-kitの実機デモ結果

汎用キットRaspberry Pi5+IMX500 とAI専用設計Qualcomm

Dev-kitで物体認識AIを評価した結果を比較してみます。どちらも学習済みモデルで、インストールして起動するだけで30FPSでのリアルタイム物体認識が可能でした。

両者の物体認識の結果は、使用するAIモデルの性能によって大きな違いが見られました。実際の物体認識の結果は次の通りです。

Qualcomm Dev-kitとRaspberry Pi5+IMX500での物体認識結果の比較

YOLOXをインストールしたQualcomm Dev-kitでは、ペットボトル、人物、椅子、テーブルなど、1画面で複数の物体を正確に認識することができました。

一方、Mobilenet SSDをインストールしたRaspberry

Pi5+IMX500が正確に認識できたのは人物のみでした。さらに、Mobilenet

SSDでは、ペットボトルをカップと誤認識したり、一瞬だけ椅子を認識したものの、その後スーツケースと誤認識したりしてしまいました。

以上の結果から、カメラによる物体認識性能は、使用するAIモデルの性能で大きくことなることを確認できました。YOLOXのような高度なAIモデルを動作させることができる、AI専用設計Qualcomm

Dev-kitの優位性を示す結果となりました。

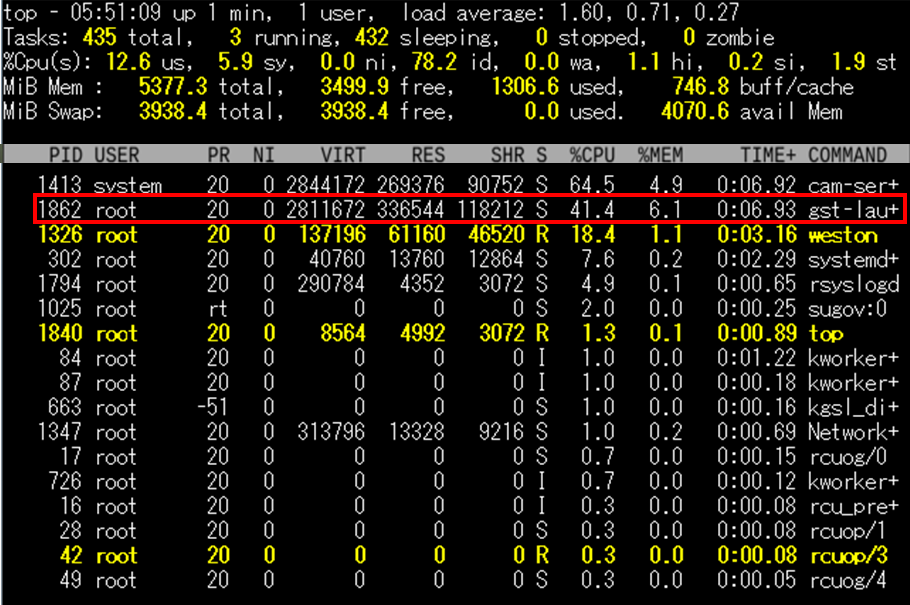

YOLOXをNPUで動作させた際のシステム負荷

ここで、参考までにYOLOXを動作させた時のシステム負荷を確認してみます。システム負荷をtopコマンドで表示した結果は、以下の通りです。YOLOXのタスクはPID

1862です。

YOLOXを動かすのに実際に消費されたメモリー容量(RES)は336,544KB(336.5MB)でした。Totalメモリー容量が5,377.3MBですから、YOLOXはメモリーの6.1%しか消費していません。NPUを搭載するQualcomm

Dev-kitでは、YOLOXを動かしてもシステムメモリーのリソースに十分な余力があることが確認できました。

TOPコマンドで表示したYOLOXのシステム負荷

エッジAI開発初期でのハードウェア選定のポイント

エッジAI開発初期における、ハードウェア選定のポイントを簡単にまとめました。

試作や教育用途であれば、手軽に入手できて情報も豊富なRaspberry

Piが有力な選択肢となります。AIの仕組みを学んだり、簡単なプロトタイプを作ったりするには最適です。

一方、実際の製品開発や量産、長期運用を考える場合は、Qualcomm製品のようなエッジAI専用デバイスが適しています。高性能なNPUによるAI推論の高速化や認識精度の向上、OTAによるソフト更新、長期供給保証、堅牢な設計、セキュリティ機能など、ビジネス現場で求められる要件をしっかり満たしています。

エッジAI開発の初期段階では、これらの情報を踏まえてデバイスを慎重に選ぶことが重要です。

エッジAI向けQualcomm製品のラインナップ紹介

Qualcomm社は、さまざまなユースケースに合わせて柔軟なエッジAI向け製品のポートフォリオを備えています。今回使用したQualcomm Dev-kitに使用されているQCS6490は、高性能なHIGHモデルになります。

Qualcomm社のエッジAI向け製品ラインナップ

Qualcomm社のエッジAI向け製品ラインナップをまとめました。デバイス選定の参考にしてください。

- Dragonwingシリーズ:産業用や商業用IoT向けに開発されたエッジAI対応のSoCです。Qualcommが長年培ってきたコネクティビティ技術と高度なAI機能を、低消費電力で提供します。

- Dragonwing Q8シリーズ:省電力かつ高性能のエッジAI処理を実現するシステムです。Wi-Fi 7接続や最適化されたAIアーキテクチャを搭載し、自律移動ロボットや産業用ドローン、カメラなど幅広いIoTアプリケーション開発に対応しています。

- Dragonwing Q6シリーズ:高性能な計算やエッジ AI 処理、接続性と電力効率を兼ね備えています。QCS5430 と QCS6490 はピン互換があり、最大8コアCPUと強力なAIエンジン(NPU・DSP)を搭載。高演算能力を必要とするロボットやスマートビジョンなどの用途に適しています。

- Dragonwing Q5シリーズ:AI機能を搭載した、省電力のSoCです。産業用・商用IoT機器向けに設計されており、ハンドヘルド、タブレット、キオスク、スキャナー、POSなどに最適です。

| 対象アプリ ケーション性能 | RETAIL タブレット、 POS等 | CONSUMER スマートホーム、 ホームロボット等 | ENTERPRISE ドローン、 IPカメラ等 | INDUSTRIAL FA機器、 自動搬送機等 |

|---|---|---|---|---|

| PREMIUM | Dragonwing Q8 (例:QCS8550) | Dragonwing Q8 (例:QCS8550) | Dragonwing Q8 (例:QCS8550) | |

| HIGH | Dragonwing Q6 (例:QCS6490) | Dragonwing Q6 (例:QCS6490) | Dragonwing Q6 (例:QCS6490) | Dragonwing Q6 (例:QCS6490) |

| MEDIUM | Dragonwing Q5 (例:QCS5430) | Dragonwing Q5 (例:QCS5430) | Dragonwing Q5 (例:QCS5430) | Dragonwing Q5 (例:QCS5430) |

| QCS8550 | QCS6490 | QCS5430 | |

|---|---|---|---|

| CPU(コア数、動作周波数) | 8コア、Up to 3.2GHz | 8コア、Up to 2.1GHz | 6コア、Up to 2.1GHz |

| GPU(名前、動作周波数) | Qualcomm® Adreno™、 680MHz | Qualcomm® Adreno™ 643L、 Up to 812MHz | Qualcomm® Adreno™ 643L、 Up to 812MHz |

| AI性能値 (TOPS:Tera Operations Per Second) | 48TOPS | 12TOPS | 3.5TOPS |

| 対応インターフェイス |

|

|

|

| 対応OS |

|

|

|

| 対応メモリー | LPDDR5x:4200MHz |

|

|

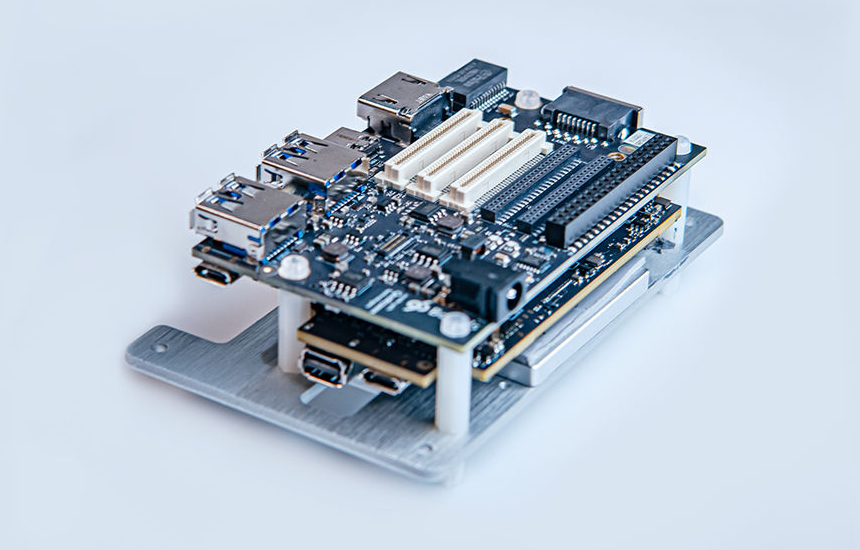

Dragonwing Q8シリーズとQ5シリーズのDevelopment Kitの紹介

Dragonwing Q8のDevelopment KitはThundercomm社からC8550 Development Kitとしてリリースされており、QCS8550プロセッサーを搭載したIoT向けの高性能開発プラットフォームです。

Thundercomm社製 C8550(QCS8550)Development Kit(出典:Thundercomm社)

Dragonwing Q5のDevelopment KitはRB3 Gen2 Lite Development KitとしてQCS5430プロセッサーを搭載しています。Linux、Android、Ubuntu、Windowsなど複数OSに対応し、USB、イーサネット、カメラ・ディスプレーポート、各種プロトコル対応のGPIO、Wi-Fi 6EとBluetooth 5.2など、豊富な接続オプションがあります。

RB3 Gen2 Lite Development kit(出典:Qualcomm)

まとめ

エッジAIの導入を成功させるには、用途や現場の要件に合わせて最適なハードウェアを選ぶことが重要です。試作や学習にはRaspberry Pi+IMX500のような汎用キットが手軽ですが、量産や産業用途には、リアルタイム性・高精度・拡張性・商用品質を兼ね備えたQualcomm製品のようなAI専用設計デバイスが選択肢となります。

関連情報

お問い合わせ

関連技術コラム

関連製品情報

コネクテッドインテリジェントエッジ(Connected Intelligent Edge)を実現する Qualcomm IoT Application Processors

QualcommのIoT Application Processorsは、AIや5Gを活用し、ロボティクスやスマートカメラなどの多様なIoTソリューションを提供します。

- Qualcomm Technologies, Inc.

- NEXT Mobility

- ICT・インダストリアル

- スマートファクトリー・ロボティクス

Qualcomm Automotive Connectivity Solution

Qualcommは、4G/5G、C-V2X、Wi-Fi、Bluetoothを活用した車載インフォテイメント向けの接続ソリューションを提供します。

- Qualcomm Technologies, Inc.

- NEXT Mobility

- ICT・インダストリアル

- スマートファクトリー・ロボティクス